继SIGGRAPH发布6篇论文后,Style3D又秀了一把AI技术肌肉!

近日,Style3D一篇AI论文已入选人工智能领域的顶级国际学术会议 NeurIPS 2024。NeurIPS (全称 Conference on Neural Information Processing Systems)是人工智能领域内公认的顶级会议之一,与ICLR和ICML并列为机器学习和人工智能研究领域“三大顶会”,具有极高的学术地位和影响力。

据NeurIPS大会官方邮件透露,今年共收到15671篇有效论文投稿,最终录用率仅为25.8%,可以看出极高的竞争性和严格性。历年论文入选的工业巨头如:谷歌、微软、Apple、NVIDIA、阿里、腾讯等。

评委点评:填补了相关领域的空白

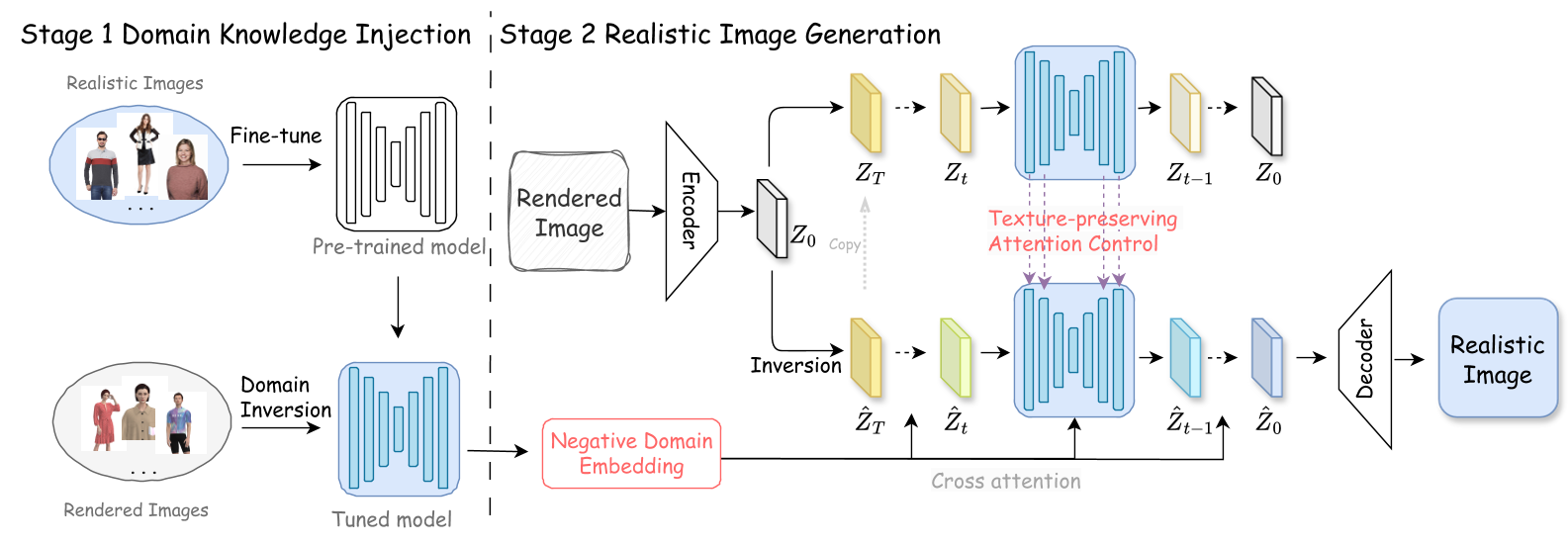

Style3D入选的论文为《让时尚更真实:基于扩散模型的纹理保持渲染到真实的图像变换》 (FashionR2R: Texture-preserving Rendered-to-Real Image Translation with Diffusion Models)

该论文研究了一个人工智能重要问题,即在3D建模和渲染的基础上,运用AI生成逼真的穿着衣物的人体图像。该问题科学研究价值大,应用场景需求广,但技术实现难度强,长期以来吸引了一大批不同领域的研究者关注。

在计算机图形学中,尽管高精度的3D建模与渲染技术能够增进图像的真实感,其高昂的计算成本及复杂性限制了广泛应用。在此背景下,生成式人工智能技术的进展,特别是针对快速生成照片级真实图像的能力,展现出巨大潜力。然而,该领域面临的核心挑战在于确保生成内容的可控性、稳定性,以及至关重要的—一致性和精确度,这是当前技术亟需克服的难点。

对此,Style3D提出了一个新颖的技术框架,通过采用两种不同的训练策略同时学习特定领域的数据知识,并对扩散模型的底层改进,提出纹理一致性保持机制(Texture-preserving Attention Control, TAC),其能够有效的保证在真实图像生成过程中保持图像的结构信息,解决从渲染到真实的时尚图像的生成问题。

虚拟模特及虚拟服装都变得更加真实

NeurIPS 2024评委对于Style3D论文点评到,“纹理保持机制TAC有效且至关重要”、“真实化效果显著”、“提出的高质量SynFashion数据集填补了相关领域的空白”、“有助于推动该领域的进一步研究”等等。获得了评委的一致认可。

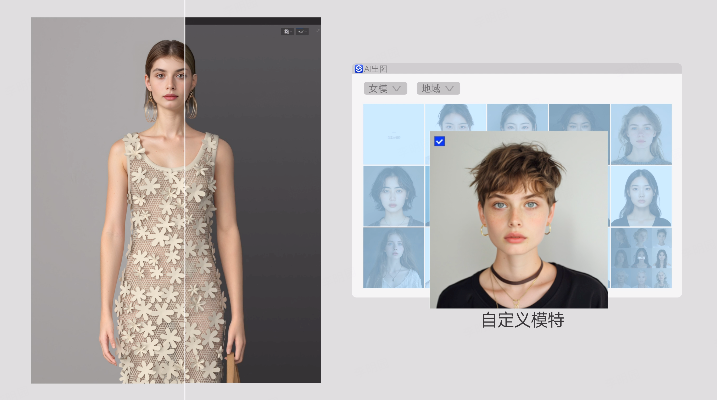

技术落地,Style3D AI 照片级真实感出图

更值得一提的是,此项技术已落地于Style3D AI产品iWish中,以灵活自由、高效低成本的生成模拍图,助力电商上新、营销推广的效率提升,降低商品素材获取成本。

服装设计者可以在Style3D Studio进行服装3D建模,确保服装制作工艺的准确性和生产数据的可靠性,实现服装设计的精准可控。再叠加Style3D iWish出图,仅需一键操作,即可生成模特、场景,以及还原服装逼真细节,仅几秒,实现肉眼难辨、4k超清的照片级效果图。

●轻松生成真人模特拍摄级效果图

一键模特生成,轻松生成各种年龄、各种肤色模特,方便快捷,提升营销上新效率。

●AI一键换景,模特、服装和背景融合

一键场景生成,快速更换各种场景,便捷高效,让模特融入千变场景。

●轻松还原服装逼真细节

一键增强服装细节,简单高效还原服装逼真细节,让3D服装更真实。

此外,Style3D还将在3D服装实时搭配软件MixMatch中植入AI功能,实时虚拟服装搭配的同时,可实现真实感的搭配方案呈现。

此前,Style3D此次6篇论文入选 SIGGRAPH 2024 已证技术实力,这次AI论文在NeurIPS 2024 中再度入选,则进一步验证了Style3D的人工智能技术研究也在前沿地位,标志着其已成为行业创新的领头羊。

除了不断筑高的技术壁垒外,Style3D也致力于将这些先进的技术成果转化为实际应用价值,通过对AI及3D产品优化与迭代,有效降低了服装行业的数字化转型门槛,推动服装产业的革新步伐,加速实现从设计到销售全链路的智能化升级。

免责声明:市场有风险,选择需谨慎!此文仅供参考,不作买卖依据。

关键词: